Era Baru AI: ChatGPT Mampu Baca Keadaan Sekitar lewat Video

Era Baru AI – Perusahaan kecerdasan buatan (artificial intelligence/AI) OpenAI kembali membawa inovasi pada fitur Advanced Voice Mode (AVM) di chatbot populernya, ChatGPT. Fitur ini awalnya dirancang untuk memungkinkan pengguna berbicara langsung dengan ChatGPT secara alami, layaknya percakapan dengan manusia. Namun kini, AVM telah di-upgrade dengan kemampuan luar biasa: menganalisis keadaan sekitar pengguna melalui video dan screen sharing.

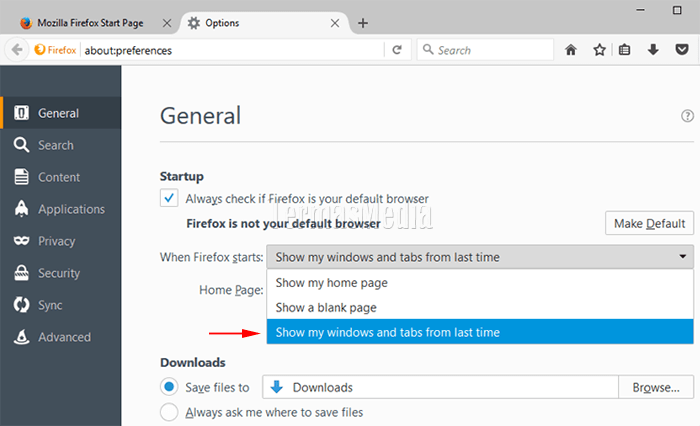

Dengan pembaruan ini, ChatGPT dapat “melihat” konten yang ditampilkan melalui kamera ponsel atau layar yang dibagikan pengguna. Prosesnya sederhana namun tetap mengutamakan privasi—pengguna harus memberikan izin akses terlebih dahulu agar fitur ini dapat digunakan. Setelah akses diberikan, ChatGPT mampu memahami apa yang “dilihatnya” melalui kamera atau layar dalam waktu nyaris real-time.

Misalnya, jika pengguna membagikan layar ponsel yang sedang menampilkan menu Pengaturan (Setting), ChatGPT dapat memberikan penjelasan tentang berbagai opsi yang ada, bahkan membantu pengguna menavigasi pilihan tertentu. Begitu pula dengan soal matematika atau dokumen yang ditampilkan di layar, ChatGPT bisa memberikan solusi atau saran secara langsung.

Kemampuan baru ini membuka banyak potensi penggunaan di berbagai situasi. ChatGPT tidak hanya menjadi asisten virtual berbasis teks atau suara, tetapi juga alat yang intuitif untuk memahami konteks visual di sekitar pengguna. Entah untuk menyelesaikan masalah teknis, menjelaskan suatu konsep yang ditampilkan di layar, atau sekadar memberikan informasi tentang objek dalam video, fitur ini menghadirkan pengalaman AI yang lebih personal dan interaktif.

Dengan fitur Advanced Voice Mode yang semakin canggih, ChatGPT kembali membuktikan bahwa AI dapat menjadi partner yang tidak hanya pintar tetapi juga praktis untuk berbagai kebutuhan sehari-hari.

ChatGPT Kini Bisa Melihat: Demonstrasi Kemampuan AI di Acara “60 Minutes”

Kemampuan ChatGPT untuk “melihat” objek di sekitar pengguna melalui kamera ponsel menjadi salah satu fitur unggulan terbaru yang dipamerkan OpenAI. Dalam sebuah demo eksklusif di acara “60 Minutes” di CNN, Presiden OpenAI, Greg Brockman, mempresentasikan fitur revolusioner ini kepada pembawa acara ternama, Anderson Cooper.

Selama demo, Cooper diminta menggambar bagian tubuh manusia di papan tulis, sementara ChatGPT menggunakan kemampuan visualnya untuk menganalisis gambar tersebut secara real-time. Tidak hanya sekadar mengenali gambar, ChatGPT memberikan respons yang relevan, mengomentari tingkat akurasi dan detail dalam gambar anatomi tubuh yang dibuat Cooper.

Demo ini menjadi bukti nyata bagaimana ChatGPT dapat berinteraksi dengan dunia visual secara intuitif. Fitur ini membuka peluang penggunaan di berbagai skenario kehidupan sehari-hari, seperti membantu siswa mempelajari anatomi tubuh, memberikan masukan terhadap desain visual, atau sekadar membantu pengguna memahami objek yang tidak dikenal.

Greg Brockman juga menjelaskan bahwa fitur ini bekerja dengan memanfaatkan kamera ponsel pengguna, memungkinkan ChatGPT untuk “melihat” melalui izin akses yang diberikan. Hal ini memastikan privasi tetap menjadi prioritas utama OpenAI dalam mengembangkan teknologi baru.

Demo inovatif ini menunjukkan potensi besar AI di masa depan, di mana chatbot tidak hanya menjadi alat percakapan berbasis teks atau suara, tetapi juga asisten visual yang cerdas, memberikan pengalaman yang semakin mendekati interaksi manusia.

ChatGPT Kini Bisa “Melihat”, Tapi Masih Rentan Halusinasi

Dalam salah satu demo fitur Advanced Voice Mode (AVM) ChatGPT, kemampuan visualnya untuk menganalisis gambar dipamerkan secara langsung. Ketika Anderson Cooper menggambar otak manusia di papan tulis, ChatGPT memberikan respons yang cukup rinci. “Lokasinya tepat. Otaknya ada di kepala. Soal bentuknya, ini cukup oke. (Bentuk) otaknya cenderung oval,” ujar ChatGPT saat mengomentari gambar Cooper.

Namun, tidak semua respons ChatGPT sempurna. Dalam demo lainnya, ketika diminta menjawab soal geometri, respons yang diberikan ternyata agak ngawur. Hal ini menyoroti kelemahan utama teknologi AI saat ini, yaitu risiko “halusinasi”—fenomena ketika AI memberikan jawaban yang kurang akurat atau tidak relevan.

Video lengkap dari demonstrasi kemampuan ChatGPT ini dapat dilihat melalui tautan yang disediakan oleh OpenAI.

Rilis Bertahap untuk Pengguna Terbatas

Fitur kemampuan “melihat” ChatGPT ini mulai dirilis OpenAI secara bertahap pada Kamis, 12 Desember 2024, di Amerika Serikat. Namun, hanya pengguna berlangganan ChatGPT Plus, Team, atau Pro yang mendapatkan akses awal. Itu pun tidak semua pelanggan layanan tersebut kebagian fitur AVM yang disempurnakan.

Sementara itu, pengguna ChatGPT Enterprise dan Edu dijadwalkan mendapatkan fitur ini mulai Januari 2025. Informasi ini dikonfirmasi melalui laporan yang dihimpun dari TechCrunch pada Jumat, 13 Desember 2024.

Perjalanan Advanced Voice Mode

Advanced Voice Mode pertama kali diperkenalkan oleh OpenAI pada Mei 2024 sebagai bagian dari upaya meningkatkan interaksi suara ChatGPT. Fitur ini merupakan pengembangan dari input dan output suara yang telah dimiliki ChatGPT sejak September 2023. Kini, dengan tambahan kemampuan visual, AVM menjadi salah satu fitur paling canggih yang menjadikan ChatGPT lebih interaktif dan kontekstual.

Meski belum sempurna, pembaruan ini membawa AI ke arah yang lebih mendekati kecerdasan manusia. Seiring pengembangannya, fitur ini memiliki potensi besar untuk berbagai aplikasi di masa depan.

Advanced Voice Mode: Asisten Digital yang Lebih Personal dan Natural

Fitur Advanced Voice Mode (AVM) dari OpenAI dirancang untuk menjadikan ChatGPT sebagai asisten digital yang intuitif, mirip dengan Google Assistant atau Siri. Namun, OpenAI mengklaim bahwa AVM mampu melampaui kemampuan asisten digital lainnya dengan respons yang lebih alami dan menyesuaikan nada bicara pengguna.

Saat pertama kali dirilis pada Juli 2024, fitur ini hanya tersedia bagi pelanggan berbayar seperti pengguna ChatGPT Plus. Dalam pengumumannya di platform X (dulu Twitter), OpenAI menyebut bahwa AVM tidak hanya mendengar perintah, tetapi juga mampu memahami suasana hati pengguna. “Advanced Voice Mode juga bisa diinterupsi, mendengarkan dan memahami nada bicara pengguna, serta membalas sesuai dengan suasana hati dan emosi yang sedang pengguna rasakan,” tulis OpenAI.

Pengembangan Melalui Uji Coba dan Feedback

Sebelum dirilis, OpenAI melakukan serangkaian uji coba ekstensif terhadap fitur ini. Lebih dari 100 orang dilibatkan dalam pengujian dengan cakupan hingga 45 bahasa. Uji coba ini bertujuan memastikan bahwa AVM dapat merespons dengan akurasi tinggi dan tetap aman dalam berbagai konteks percakapan.

Selain itu, OpenAI juga mengumpulkan masukan dari pengguna awal selama tahap perilisan versi Alpha. Feedback ini digunakan untuk menyempurnakan cara AVM menjawab pertanyaan pengguna tanpa melanggar aturan atau etika yang berlaku.

Fitur dan Keamanan yang Diutamakan

Advanced Voice Mode dilengkapi kemampuan untuk memblokir permintaan yang tidak wajar, seperti konten yang mengandung kekerasan atau melibatkan hak cipta. Pada tahap awal peluncuran, AVM hadir dengan empat jenis suara yang dirancang untuk memberikan pengalaman percakapan yang lebih personal.

Dengan kemampuan untuk mendengarkan, memahami, dan menyesuaikan respons berdasarkan konteks emosional, fitur ini membawa interaksi AI ke level yang lebih tinggi. Meski masih dalam pengembangan, Advanced Voice Mode menjanjikan pengalaman asisten digital yang lebih aman, adaptif, dan mendukung kebutuhan sehari-hari pengguna.

Baca juga artikel lainnya dari cuaninaja.id